当前正处于国产大模型蓬勃发展的时代浪潮之中,随着以DeepSeek为代表的多款优秀国产大模型相继开源,不仅撬动了数以亿计的活跃用户,更为GpuGeek等AI基础设施平台带来了前所未有的发展机遇与挑战。作为连接算力与应用的"桥梁",GpuGeek通过创新服务模式和全栈技术架构,正积极应对并引领这一轮AI基础设施变革。

国产算力崛起带来的发展机遇

国产大模型在效果和性能上的突破,为AI Infra平台带来了三大发展机遇。首先是计算资源依赖得到缓解,显著降低了AI模型的训练推理成本,使得云服务商能够以更低成本提供更强大的AI服务。其次是推动了AI基础设施的全栈协同优化,包括云边协同、大小模型协同等多个层面的升级。第三是软硬件高度集成的解决方案促进了大模型在私有环境的广泛落地。

以GpuGeek为例,平台积极把握这些机遇,通过全栈式AI解决方案深度整合生态算力资源。在国产算力方面,平台已正式上线华为昇腾910B 64G GPU资源。这款面向AI训练和推理场景的高性能处理器,采用先进的制程工艺和架构设计,不仅提供强大的单卡算力,其高带宽内存和优化的计算单元设计还显著提升了数据处理效率,有效缩短了AI模型的训练周期。

平台创新应对新型挑战

国产算力的崛起也为AI Infra平台带来了新的挑战。首要挑战是如何实现国产异构算力的高效适配与管理。GpuGeek通过开放合作的态度,积极拥抱国内优秀芯片厂商和解决方案提供商,构建更具弹性的国产算力资源池,并不断优化这些资源的调度、管理和使用体验。

在底层技术服务方面,GpuGeek提供对象存储、NAS存储、开发工具、模型部署、模型API等全方位能力,支持各类开源框架如TensorFlow、PyTorch、PaddlePaddle等。平台创新性地采用算力合作、联合运营、收益分成结算等方式,构建GPU算力交易网络,有效连接供需两端。

特别值得一提的是,面对企业级AI应用私有化部署的需求增长,GpuGeek推出了裸金属服务器解决方案。通过物理GPU直通技术,为用户提供独占的GPU资源,确保推理任务的稳定性和可靠性,特别适合高性能计算、企业关键应用等场景。

未来发展与战略布局

随着国产算力的持续发展,AI Infra平台将迎来更大的发展空间。GpuGeek已经开始布局下一阶段的发展战略,将对昇腾910B等国产芯片底层进行优化,提升其与云平台各项服务的融合度,在弹性计算、存储、网络等方面进行协同优化。

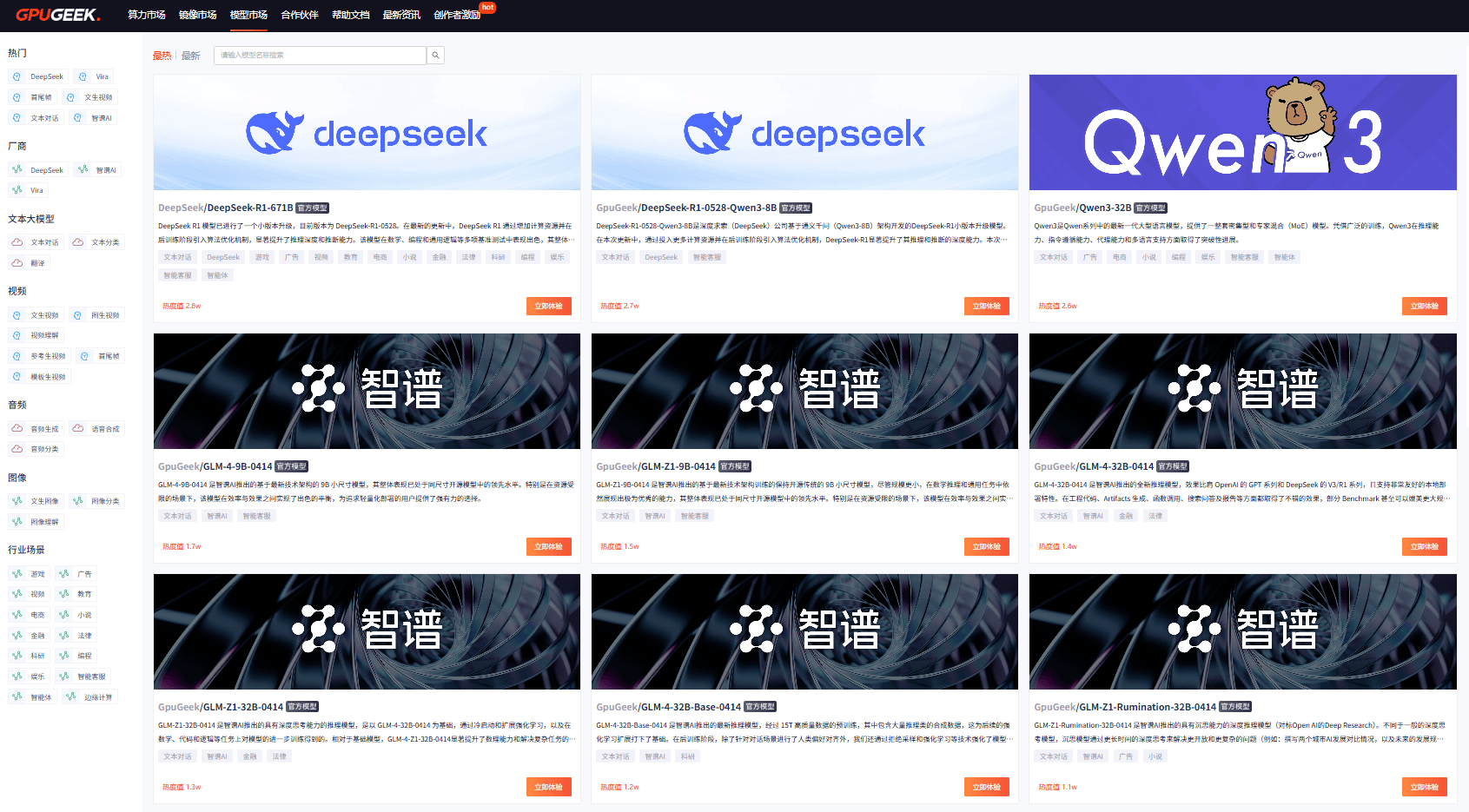

在生态建设方面,GpuGeek模型市场已经汇聚了包括Qwen3、智谱GLM-Z1系列、DeepSeek-V3等重要模型资源。特别是Qwen3大模型以"混合推理架构"在多个领域实现突破,展现了国产模型的创新活力。

通过持续完善基础服务,提供更多的GPU资源、更便捷的模型训练和推理服务,GpuGeek正在构建一个更开放、更高效的AI基础设施生态系统,为国产算力的蓬勃发展提供坚实支撑,推动AI技术在各行各业的深度应用。